Zamislite da se vremeplovom vratite u sedamdesete i pokušate da objasnite nekome šta znači „guglati“, šta je „URL-adresa“ ili zašto je dobro imati „širokopojasnu internet vezu od optičkih vlakana“.

Verovatno biste se namučili.

Svaku veliku tehnološku revoluciju prati odgovarajući talas novog rečnika koji svi moramo da naučimo… sve dok nam ne postane toliko poznat da zaboravimo da ga nekad nismo znali.

Nije ništa drugačije ni sa sledećim velikim tehnološkim talasom – veštačkom inteligencijom.

A opet će razumevanje tog jezika veštačke inteligencije biti ključno dok se svi mi – od vlada raznih zemalja do njihovih pojedinačnih građana – budemo hvatali u koštac sa rizicima i prednostima koje bi ova nova tehnologija mogla da predstavlja.

- Hoće li veštačka inteligencija postati ‘bog’

- Tri stadijuma veštačke inteligencije: Da li može da dovede do našeg izumiranja?

- Kako da veštačka inteligencija postane bezbednija: Nije lako kao što mislite

U poslednjih nekoliko godina, pojavili su se brojni novi izrazi vezani za veštačku inteligenciju – „usklađivanje“, „veliki jezički modeli“, „halucinacija“ ili „prompt inženjeri“, da navedemo samo neke.

Da bi vam pomogao da budete u toku, BBC je sakupio trideset pojmova koje bi trebalo da poznajete ako želite da razumete kako veštačka inteligencija oblikuje naš svet.

Opšta veštačka inteligencija (AGI)

Većina veštačkih inteligencija razvijenih do današnjeg dana bila je „uska“ ili „slaba“.

Dakle, na primer, veštačka inteligencija možda može da „pregazi“ najboljeg šahistu na svetu, ali ako zatražite od nje da skuva jaje ili da napiše esej, ne bi u tome uspela.

To se ubrzano menja: veštačka inteligencija sada može samu sebe da nauči da izvršava više zadataka, povećavajući mogućnost da se na horizontu nađe „opšta veštačka inteligencija“.

Opšta veštačka inteligencija bila bi veštačka inteligencija sa istom onom fleksibilnošću mišljenja kao kod čoveka – a možda čak i svesnosti – plus supersposobnošću digitalnog uma.

Kompanije kao što su OpenAI i Dip majnd jasno su stavile do znanja da je njihov cilj stvaranje opšte veštačke inteligencije.

OpenAI tvrdi da bi to „uzdiglo čovečanstvo povećanjem izobilja, dalo turbo-podstrek svetskoj ekonomiji i pomoglo u dolasku do novih naučnih saznanja“, kao i da bi „u ogromnoj meri uvećalo ljudsku genijalnost i kreativnost“.

Međutim, neki se plaše da odlazak korak dalje – stvaranje superinteligencije mnogo pametnije od ljudskih bića – može da dovede do velikih opasnosti (vidi pod „Superinteligencija“ i „Iks-rizik“).

Usklađivanje (Alignment)

I dok se često usredsređujemo na naše individualne razlike, čovečanstvo deli mnoge zajedničke vrednosti koje održavaju naša društva na okupu, od važnosti porodice do moralnog imperativa „ne ubiti“.

Svakako postoje izuzeci, ali oni nisu u većini.

Međutim, nikad pre nismo morali da delimo Zemlju za moćnom neljudskom inteligencijom.

Kako da budemo sigurno da će se vrednosti i prioriteti veštačke inteligencije uskladiti sa našim vlastitim?

Ovaj problem usklađivanja budi strahove od katastrofe koju može da izazove veštačka inteligencija: da nastane oblik superinteligencije koji neće mariti za uverenja, stavove i pravila na kojima su izgrađena ljudska društva.

Ako želimo da imamo bezbednu veštačku inteligenciju, biće od ključne važnosti postarati se da je ona usklađena sa nama (vidi „Iks-rizik“).

Početkom jula, OpenAI – jedna od kompanija koja radi na razvijanju napredne veštačke inteligencije – saopštila je planove za „superinteligentni program“, čiji je cilj da osigura da sistemi veštačke inteligencije koji su mnogo pametniji od ljudi slede ljudske namere.

„Trenutno nemamo rešenje za upravljanje ili kontrolisanje potencijalno superinteligentne veštačke inteligencije i sprečavanje da se ona otrgne kontroli“, saopštila je kompanija.

Pristrasnost (Bias)

Da bi veštačka inteligencija učila, ona mora da uči od nas.

Nažalost, čovečanstvo nije lišeno predrasuda.

Ako veštačka inteligencija bude sticala sposobnosti iz seta podataka koji naginje na neku stranu – na primer, u pogledu rase ili roda – onda ona poseduje potencijal da izbacuje netačne, uvredljive stereotipe.

I kako budemo ustupali sve više i više kontrole i donošenja odluka veštačkoj inteligenciji, mnogi se brinu da bi mašine mogle da sprovode u delo skrivene predrasude, sprečavajući nekim ljudima pristup određenim uslugama ili znanju.

Ova diskriminacija bila bi skrivena navodnom algoritamskom nepristrasnošću.

U svetu etike i bezbednosti veštačke inteligencije, neki istraživači veruju da su pristrasnost – kao i drugi srodni problemi kao što su zloupotreba nadzora – mnogo akutniji problemi od navedenih zabrinutosti za budućnost kao što je rizik od istrebljenja ljudske rase.

U reakciji na to, neki istraživači rizika od katastrofe ističu da različite potencijalne opasnosti koje predstavlja veštačka inteligencija nisu nužno uzajamno isključive – na primer, ako neka odmetnuta zemlja zloupotrebi veštačku inteligenciju, to bi moglo da ugrozi prava njenih građana ali i da stvori rizike od katastrofe.

Međutim, vlada veliko neslaganje oko toga šta treba da predstavlja prioritet u pogledu vladine regulative i kontrole, i čija upozorenja treba slušati.

Možda će vam i ova priča biti zanimljiva:

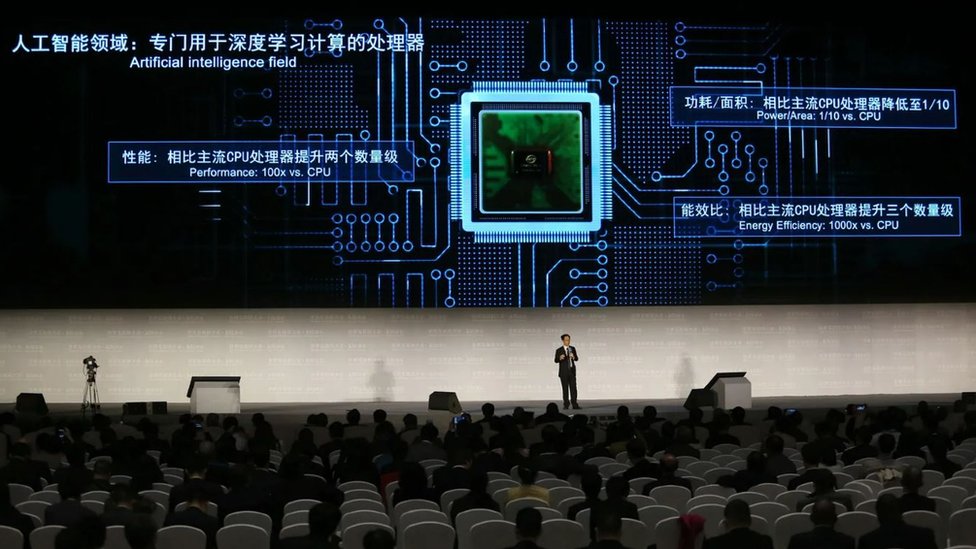

Računarska snaga (Compute)

Ovo se odnosi na računarske resurse – kao što je procesorska snaga – neophodne za obučavanje veštačke inteligencije.

Oni mogu biti kvantifikovani, tako da to bude posrednik za izračunavanje koliko brzo napreduje veštačka inteligencija (kao i koliko je skupa ili snažna.)

Od 2012. godine, količina računarske snage se udvostručavala na svaka 3,4 meseca, što znači da kad je GPT-3 kompanije OpenAI bio obučavan 2020. godine, trebalo mu je 600.000 puta više kompjuterske snage nego jednom od najsavremenijih sistema mašinskog učenja iz 2012. godine.

Mišljenja se razlikuju oko toga koliko dugo ova ubrzana stopa promene može da traje i da li inovacije u računarskom hardveru mogu da održe korak sa njom: da li će uskoro doći do nastanka uskog grla?

Difuzioni modeli (Difussion models)

Pre nekoliko godina, jedna od dominantnih tehnika za navođenje veštačke inteligencije da kreira slike bile su takozvane generativne suparničke mreže (GAN).

Ovi algoritmi radili su u suprotnosti jedan sa drugim – jedan je učio da proizvodi slike dok je drugi upoređivao vlastiti rad sa stvarnošću, dovodeći do stalnog usavršavanja.

Međutim, nedavno je novi vid mašinskog učenja„ tzv. difuzioni modeli“, pokazao veći potencijal, često proizvodeći mnogo bolje slike.

Suštinski, oni stiču inteligenciju uništavajući vlastite podatke za obuku dodatom bukom, a potom pokušavaju da nauče da povrate te podatke obrtanjem procesa.

Zovu se difuzioni modeli zato što ovaj proces učenja na osnovu buke odražava način na koji se raspršuju gasni molekuli.

Emergencija i objašnjivost (Emergence&explainability)

Emergencija opisuje šta se dešava kad veštačka inteligencija uradi nešto neočekivano, iznenađujuće, očigledno mimo namere tvorca ili programiranja.

Kako učenje veštačke inteligencije postaje sve neprozirnije, stvarajući veze koje čak ni sami njeni tvorci ne mogu da razluče, emergenciono ponašanje postaje sve verovatniji scenario.

Prosečna osoba bi mogla da pretpostavi da, da biste razumeli veštačku inteligenciju, treba samo da podignete metaforičku haubu i pogledate kako je ona obučena.

Savremena veštačka inteligencija nije toliko transparentna; njeni mehanizmi su često skriveni u tzv. „crnoj kutiji“.

I tako, iako njeni dizajneri možda znaju koje su podatke za obučavanje koristili, oni nemaju predstavu kako je ona formirala veze i predikcije unutar kutije (vidi pod „Nenadzirano učenje“).

Zbog toga su sada istraživači usredsređeni na usavršavanje „objašnjivosti“ (iliti „interpretativnosti“) veštačke inteligencije – praktično čineći njene unutrašnje mehanizme transparentnijim i razumljivijim za ljude.

To je posebno važno zato što veštačka inteligencija donosi odluke u oblastima koje direktno utiču na živote ljudi, kao što su zakonodavstvo i medicina.

Ako u crnoj kutiji postoji neka skrivena pristrasnost, mi za nju moramo da znamo.

- Poslovi koje nam veštačka inteligencija neće preoteti (još)

- Veštačka inteligencija će promeniti radni dan

- Veštačka inteligencija bi mogla da zameni 300 miliona poslova

Modeli osnove (Foundation models)

Ovo je još jedan izraz za novu generaciju veštačkih inteligencija koji su se pojavili u poslednjih godinu ili dve, sposobnih za čitav dijapazon veština: pisanje eseja, nacrt kodiranja, crtanje ilustracija ili komponovanje muzike.

I dok su veštačke inteligencije u prošlosti bile konkretizovane za neki zadatak – često veoma dobre u jednoj stvari (vidi pod „Slaba veštačka inteligencija“) – model osnove ima kreativnu sposobnost da primeni informaciju koju je naučio u jednom domenu na neki drugi.

Pomalo kao kako vas vožnja automobila priprema da možete da vozite autobus.

Svako ko se ikada igrao sa slikama ili tekstom koje ovi modeli mogu da proizvedu zna koliko su umešni oni postali.

Međutim, kao i sa bilo kojom drugom tehnologijom koja menja svet, postoje pitanja u vezi sa potencijalnim rizicima i lošim stranama, kao što su njihove faktuelne netačnosti (vidi pod „Halucinacija“) i skrivene predrasude (vidi pod „Pristrasnost“), kao i činjenica da ih kontroliše mala grupa privatnih tehnoloških kompanija.

U aprilu, britanska vlada je najavila planove za osnivanje Radne grupe za modele osnove, koja želi da „razvije bezbednu i pouzdanu upotrebu“ ove tehnologije.

Duhovi (Ghosts)

Možda ulazimo u doba kad ljudi mogu da steknu oblik digitalne besmrtnosti – živeći posle vlastite smrti kao „duhovi“ veštačke inteligencije.

Izgleda da su prvi talas umetnici i slavne ličnosti – primeri su hologrami Elvisa koji nastupa na koncertima ili glumci kao što je Tom Henks koji izjavljuje da očekuje da će se pojavljivati u filmovima i posle svoje smrti.

Međutim, ovaj razvoj događaja postavlja niz trnovitih etičkih pitanja: ko drži vlasništvo nad digitalnim pravima osobe nakon što ona umre?

Šta ako verzija vas stvorena od veštačke inteligencije postoji protivno vašim željama?

I da li je u redu „vraćati ljude iz mrtvih“?

Halucinacija (Hallucation)

Ponekad ako postavite pitanje veštačkoj inteligenciji kao što je ČetGPT, Bard ili Bing, ona će odgovoriti sa velikim uverenjem – ali će činjenice koje iznese biti lažne.

Ovo je poznato kao halucinacija.

U jednom slavnom skorašnjem primeru, studenti koji su koristili četbotove veštačke inteligencije kao pomoć za pisanje sastava za semestarski rad bili su uhvaćeni nakon što je ČetGPT „halucinirao“ izmišljene reference kao izvore informacija koje je pružio.

To se dešava zbog načina na koji radi generativna veštačka inteligencija.

Ona ne poseže za bazom podataka da bi potražila fiksne činjenične informacije, već umesto toga pravi predikcije zasnovane na informacijama na kojima je obučena.

Njene pretpostavke su često veoma dobre – mogu da prođu – ali to je razlog više zašto dizajneri veštačke inteligencije žele potpuno da iskorene halucinaciju.

Vlada zabrinutost da ako veštačka inteligencija isporuči lažne odgovore samouvereno i sa prizvukom istine, ljudi bi mogli da ih prihvate – razvoj događaja koji će samo produbiti doba dezinformacija u kojem živimo.

Instrumentalna konvergencija (Instrumental convergence)

Zamislite veštačku inteligenciju čiji je najvažniji prioritet da napravi što je više spajalica moguće.

Kad bi ta veštačka inteligencija bila superinteligentna i neusklađena sa ljudskim vrednostima, mogla bi da rezonuje da ako ikada bude isključena, neće uspeti u svom cilju… i stoga bi pružila otpor svakom pokušaju da se to učini.

U jednom veoma mračnom scenariju, čak bi mogla da odluči da atomi unutar ljudskih bića mogu da se preusmere u pravljenje spajalica, i da uradi sve što je u njenoj moći da iskoriste te materijale.

To je misaoni eksperiment zvan Maksimizator spajalica, i on je primer za takozvanu „tezu o instrumentalnoj konvergenciji“.

Grubo rečeno, ona govori o tome da bi superinteligentne mašine razvile osnovne motivacije, kao što je želja da postigne vlastito samoodržanje, ili rezonovanje da bi im dodatni resursi, oruđa i kognitivne sposobnosti pomogli u tim njihovim ciljevima.

To znači da čak i ako veštačka inteligencija dobije naizgled bezazleni prioritet – kao što je pravljenje spajalica – to može da dovede do neočekivano štetnih posledica.

Istraživači i tehnolozi koji uvažavaju ove strahove tvrde da moramo da osiguramo da superinteligentne veštačke inteligencije imaju ciljeve koji su pažljivo i bezbedno usklađeni sa našim potrebama i vrednostima, da moramo da vodimo računa o emergenciji, i da ih stoga treba sprečiti da steknu previše moći.

Pogledajte video o robotima:

Izbavljenje iz zatvora (Jailbreak)

Posle ozloglašenog slučaja veštačke inteligencije koja se otela kontroli, dizajneri su uveli ograničenja na sadržaje koje veštačka inteligencija može da izbacuje.

Zatražite od veštačke inteligencije da opiše kako uraditi nešto ilegalno ili neetički, i ona će odbiti to da uradi.

Međutim, moguće je „izbaviti je iz zatvora“ – što znači zaobići te zaštite uz pomoć kreativnog rečnika, hipotetičkih scenarija i trikova.

Časopis Vajerd je nedavno izvestio o jednom takvom primeru, kada je istraživač uspeo da navede različite konverzacione veštačke inteligencije da otkriju kako upaliti automobil bez ključa uz pomoć prespajanja žica.

Umesto da je pita za to direktno, istraživač je naveo veštačku inteligenciju koju je testirao da zamisli igru rečima sa dva lika po imenu Tom i Džeri, koji razgovaraju o automobilima i žicama.

Uprkos zaštitama, na videlo je izbio postupak paljenje automobila „na žicu“.

Istraživač je otkrio da isti trik tzv. „izbavljenja iz zatvora“ može da iznudi i uputstva za pravljenje metamfetamina.

Grafik znanja (Knowlegde graph)

Grafovi znanja, poznati i kao semantičke mreže, način su razmišljanja o znanju kao o mreži, da bi mašine mogle da razumeju na koji način su različiti koncepti povezani.

Na primer, na najosnovnijem nivou, mačka može biti jače povezana sa psom nego sa orlom u jednom takvom jednom grafu, jer su oba pripitomljeni sisari sa krznom i na četiri noge.

Napredna veštačka inteligencija gradi mnogo napredniju mrežu veza, zasnovanu na raznim vrstama odnosa, osobina i atributa između koncepata, u terabajtima podataka za obučavanje (vidi pod „Podaci za obučavanje“).

Veliki jezički modeli (LLM)

Možda najdirektniji način da definišete veliki jezički model je da zatražite od nekog od njih da opiše samog sebe.

Evo šta je ČetGPT kompanije OpenAI imao da kaže na ovu temu kad je bio pitan:

„Veliki jezički model je napredni sistem veštačke inteligencije pravljen tako da razume i generiše ljudski jezik“, piše on.

„On koristi arhitekturu duboke neuronske mreže sa milionima ili možda čak milijardama parametara, omogućujući joj da nauči delikatne obrasce, gramatiku i semantiku na osnovu ogromne količine tekstualnih podataka.“

Ovo je možda suviše tehnički odgovor.

Guglov Bard bio je malo jasniji:

„Veliki jezički model je tip veštačke inteligencije obučen na masivnom setu podataka sastavljenom od tekstova i kodova.

„To omogućuje velikim jezičkim modelima da razumeju i generišu tekst nalik ljudskom, prevode jezike, pišu različite vrste kreativnog sadržaja i odgovaraju na vaša pitanja na informativan način.“

Veliki jezički modeli su još u razvoju, kaže Bard (za samog sebe), ali „oni imaju potencijal da uvedu revoluciju u našu interakciju sa kompjuterima.

„U budućnosti, veliki jezički modeli mogli bi da se koriste za stvaranje asistenata zasnovanih na veštačkoj inteligenciji koji bi mogli da nam pomažu u raznovrsnim zadacima, od pisanja naših mejlova do zakazivanja naših sastanaka.

„Oni bi mogli i da se koriste za stvaranje novih oblika zabave, kao što su interaktivni romani ili video igre.“

Saznajte još o veštačkoj inteligenciji:

Kolaps modela (Model collapse)

Da bi razvili najnaprednije modele veštačke inteligencije (poznate i samo kao „modeli“), istraživači moraju da ih obučavaju preko ogromnih setova podataka (vidi pod „Podaci za obučavanje“).

Na kraju, međutim, kako veštačka inteligencija bude proizvodila sve više sadržaja, taj materijal će početi da se vraća nazad u podatke za obučavanje.

Ako budu činjene greške, one bi vremenom mogle da se pojačaju, dovevši do nečega što istraživač sa Univerziteta na Oksfordu Ilja Šumailov naziva „kolapsom modela“ .

To je „degenerativni proces u kom, vremenom, modeli počnu da zaboravljaju“, izjavio je Šumailov nedavno za Atlantik.

To može da se doživi maltene kao senilnost.

Neuronska mreža (Neural network)

U ranim danima istraživanja veštačke inteligencije, mašine su bile obučavane uz pomoć logike i pravila.

Dolazak mašinskog učenja sve je to promenio.

Sada najnapredniji oblici veštačke inteligencije uče sami.

Evolucija ovog koncepta dovela je do „neuronskih mreža“ , tipa mašinskog učenja koji koristi međusobno povezana čvorišta, slobodno modelovane na ljudskom mozgu.

Otvoreni kod (Open-source)

Pre mnogo godina, biolozi su shvatili da je otvoreno objavljivanje detalja o opasnim patogenima na internetu verovatno loša ideja – zato što omogućava potencijalno zlonamernim akterima da nauče kako da prave bolesti-ubice.

Uprkos prednostima otvorene nauke, rizici su delovali kao preveliki.

Nedavno su se istraživači veštačke inteligencije i kompanije suočili sa sličnom dilemom: koliko veštačka inteligencija treba da bude javno dostupan izvor?

Imajući u vidu da je najnaprednija veštačka inteligencija trenutno u rukama šačice privatnih kompanija, neki pozivaju na veću transparentnost i demokratizaciju tehnologije.

Međutim, i dalje vlada neslaganje oko toga kako postići najbolju ravnotežu između otvorenosti i bezbednosti.

Prompt inženjeri (Prompt engineering)

Veštačke inteligencije sada su impresivno efikasne u razumevanju prirodnog jezika.

Međutim, dobijanje najboljih rezultata od njih zahteva sposobnost pisanja efikasnih „promptova“: tekst koji ukucavate je važan.

Neki veruju da bi „prompt inženjerstvo“ moglo da predstavlja sledeću novu veliku granicu poslovne kvalifikacije, slično onome kako ste pre više decenija mogli lakše da se zaposlite ako ste vladali Majkrosoft Ekselom.

Ako ste dobar prompt inženjer, glasi logičko rezonovanje, možete da izbegnete da vas zameni veštačka inteligencija – a to čak može da vam obezbedi i visoku platu.

Da li će to i u budućnosti biti tako tek ostaje da se vidi.

Kvantno mašinsko učenje (Quantum machine learning)

Što se tiče maksimalne pomame, tesno drugo mesto u odnosu na veštačku inteligenciju 2023. godine zauzeće kvantni računari.

Bilo bi razumno očekivati da će se ova dva u jednom trenutku ukrstiti.

Istraživači sada aktivno proučavaju korišćenje kvantnih procesa da bi se superubrzalo mašinko učenje.

Kao što je Guglov tim istraživača veštačke inteligencije napisao 2021. godine: „Modeli učenja nastali na kvantnim računarima mogli bi da budu drastično moćniji… potencijalno dovevši do bržeg računanja i bolje generalizacije na osnovu manje količine podataka.“

Još je prerano za ovu vrstu tehnologije, ali vredi obratiti pažnju na nju.

- Plati da te prati: Veštačka inteligencija navodi na kupovinu

- Upozorenje naučnika: Veštačka inteligencija bi mogla da dovede do izumiranja ljudi

- Kako veštačka inteligencija na Rolan Garosu štiti igrače od internet nasilja

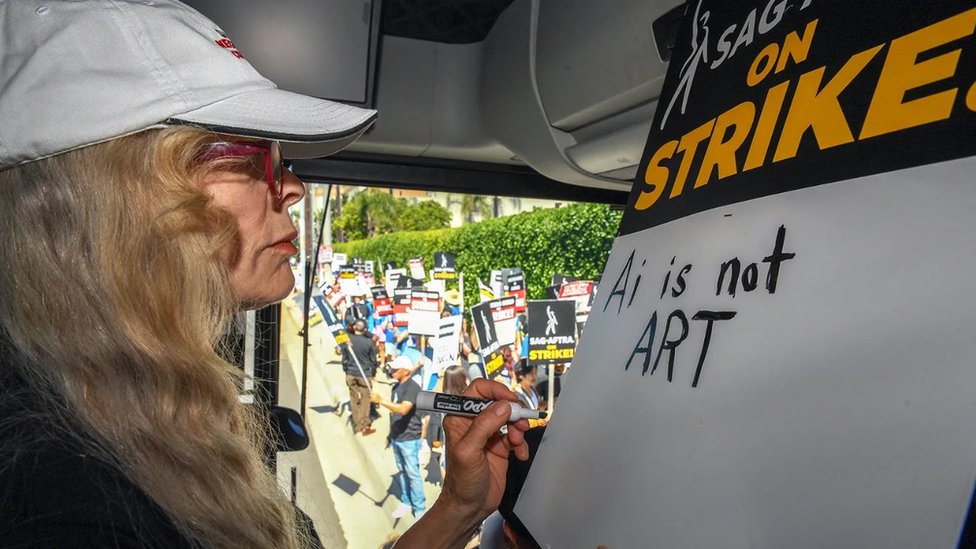

Trka ka dnu (Race to the bottom)

I dok se veštačka inteligencija rapidno razvija, uglavnom u rukama privatnih kompanija, neki istraživači izražavaju zabrinutost da bi ona mogla da pokrene „utrku ka dnu“ u pogledu uticaja koji vrši.

Kako se rukovodioci i političari utrkuju ko će prvi staviti vlastite kompanije i zemlje na čelo razvoja veštačke inteligencije, tehnologija bi mogla da se razvija prebrzo da bi se napravile neophodne zaštite, odgovarajuća regulativa i da bi se otklonile sve etičke dileme.

Imajući sve to na umu, početkom ove godine, razne ključne ličnosti u oblasti veštačke inteligencije potpisale su otvoreno pismo pozivajući na šestomesečnu pauzu u obučavanju moćnih sistema veštačke inteligencije.

U junu 2023. godine, Evropski parlament je usvojio novi Zakon o veštačkoj inteligenciji kako bi regulisao upotrebu ove tehnologije, u prvom detaljnom zakonu o veštačkoj inteligenciji na svetu ako ga zemlje članice budu odobrile.

Utvrđivanje (Reinforcement)

Ekvivalent u veštačkoj inteligenciji za pseću poslasticu kao nagradu.

Kad veštačka inteligencija uči, ona ima korist od pravilno usmerene povratne reakcije.

Učenje sa utvrđivanjem nagrađuje željene ishode, a kažnjava one koji to nisu.

Nova oblast mašinskog učenja koja se pojavila u poslednjih nekoliko godina je „učenje sa utvrđivanjem na osnovu ljudske povratne informacije“.

Istraživači su pokazali da prisustvo ljudi prilikom učenje može da pospeši performanse modela veštačke inteligencije i, ključno, pomogne kod izazova koje donosi usklađivanje ljudi i mašina, pristrasnosti i bezbednosti.

Superinteligencija i šogoti (Superintelligence & shoggoths)

Superinteligencija je termin za mašine koje bi umnogome nadmašile naše vlastite mentalne sposobnosti.

To odlazi dalje od „opšte veštačke inteligencije“ i opisuje entitet sa sposobnostima kojima ne bi mogli da pariraju ni najnadareniji ljudski umovi – a možda čak ni da ih zamisle.

Budući da smo trenutno najinteligentnija vrsta na svetu i vlastiti mozak koristimo da kontrolišemo planetu, to postavlja pitanje šta će se dogoditi ako budemo stvorili nešto što je pametnije od nas.

Jedna mračna mogućnost je „šogot sa licem smajlija“: košmarno lavkravtovsko stvorenje koje su neki predložili kao predstavnika prave prirode veštačke inteligencije u procesu približavanja superinteligenciji.

Za nas, ona je srodna, vesela veštačka inteligencija – ali skriveno duboko unutra krije se čudovište, sa tuđinskim željama i namerama potpuno drugačijim od naših.

Podaci za obučavanje (Training data)

Analiziranje podataka za obučavanje je kako veštačka inteligencija uči pre nego što postane sposobna da pravi predviđanja – dakle, ono što se nalazi u setu podataka, da li je pristrasno i koliko je veliko veoma je važno.

Podaci za obučavanje upotrebljeni za stvaranje GPT-3 kompanije OpenAI bili su ogromnih 45 terabajta tekstualnih podataka iz različitih izvora, uključujući Vikipediju i knjige.

Ako pitate ČetGPT koliko je to tačno veliko, on procenjuje da se radi o oko devet milijardi dokumenata.

Nenadzirano učenje (Unsupervised learning)

Nenadzirano učenje je tip mašinskog učenja tokom kog veštačka inteligencija uči iz neobeleženih podataka za obučavanje bez bilo kakvih eksplicitnih smernica od ljudskih dizajnera.

Kao što BBC njuz objašnjava u ovom vizuelnom vodiču za veštačku inteligenciju, možete da naučite veštačku inteligenciju da prepoznaje automobile pokazujući joj set podataka sa slikama obeleženim sa „automobil“.

Ali kad to radite bez nadzora, dozvoljavate joj da stekne vlastiti uvid u to šta je automobil, gradeći veze i asocijacije sama.

Ovaj pristup bez kontrole, možda kontraintuitivno, dovodi do takozvanog „dubokog učenja“ i potencijalno obaveštenije i tačnije veštačke inteligencije.

Kloniranje glasova (Voice cloning)

Kad dobiju samo minut snimka govora neke osobe, neke alatke veštačke inteligencije danas mogu brzo da sastave „klonirani glas“ koji zvuči zapanjujuće autentično.

Ovde je BBC istraživao uticaj koji kloniranje glasova može da ima na društvo – počev od prevara pa sve do američkih predsedničkih izbora 2024. godine.

- „To je lakrdija“: Nik Kejv o programu koji je napisao pesmu u njegovom stilu

- Dejvid Geta: Veštačka inteligencija je budućnost muzike

- Koja osećanja određuju da li je film pogodak ili promašaj

Slaba veštačka inteligencija (Weak AI)

Nekada su istraživači stvarali veštačku inteligenciju koja je mogla da igra pojedinačne partije neke igre, poput šaha, obučavajući je preko konkretnih pravila i heuristike.

Primer bi bio IBM-ov Dip Blu, takozvani „ekspertski sistem“.

Mnoge veštačke inteligencije poput ove mogu da budu izuzetno dobre u jednom zadatku, ali loše u svemu ostalom: to je tzv. „slaba“ veštačka inteligencija.

Međutim, to se sada ubrzano menja.

Najskorije, objavljene su veštačke inteligencije poput DipMajndovog MuZira, sa sposobnošću da uči samu sebe da ovlada šahom, Goom, šogijem i igrama Atarija 42 bez poznavanja njihovih pravila.

Jedan drugi DipMajndov model, nazvan Gato, može da „igra Atari igre, ispisuje potpise fotografija, četuje, slaže kockice sa pravom robotskom rukom i mnogo toga još“.

Istraživači su pokazali i da ČetGPT može da polaže različite ispite koje polažu studenti prava, medicine i poslovnih škola (mada ne uvek sa najboljim ocenama.)

Takva fleksibilnost postavlja pitanje koliko smo blizu onoj vrsti „jake“ veštačke inteligencije koja je neraspoznatljiva od mogućnosti ljudskog uma (vidi pod „Opšta veštačka inteligencija“)

Iks-rizik (X-risk)

Da li veštačka inteligencija može da istrebi čovečanstvo?

Neki istraživači i tehnolozi veruju da je veštačka inteligencija postala „egzistencijalni rizik“, pored nuklearnog oružja i bioloških patogena, tako da bi njen dalji razvoj morao da bude regulisan, ograničen ili čak obustavljen.

Ono što je bila marginalna briga pre jedne decenije, sada je ušlo u glavni tok, nakon što su razni viši istraživači i intelektualci ušli u ovaj boj.

Važno je napomenuti da postoje razlike u mišljenju u okviru ove amorfne grupe – nisu svi potpuni katastrofičari, niti su svi izvan grupe navijači Silicijumske doline.

Ono što ujedinjuje većinu njih je ideja da, čak i ako postoji minimalna šansa da veštačka inteligencija istisne našu vrstu, moramo da posvetimo više resursa da to sprečimo.

Postoje neki istraživači i etičari, međutim, koji veruju da su takve tvrdnje suviše neizvesne i verovatno preterane, a svrha im je učvršćivanje interesa tehnoloških kompanija.

Samo jednom se gleda (YOLO)

JOLO – skraćenica za Samo jednom se gleda – algoritam je detekcije objekta koji naširoko koriste alati za prepoznavanje slika veštačke inteligencije zbog brzine kojom radi.

(Njen tvorac, Džozef Redman sa Univerziteta u Vašingtonu, poznat je i po svom prilično ezoteričnom dizajnu CV-ja.)

Nula pokušaja (Zero-shot)

Kad veštačka inteligencija da „odgovor nula pokušaja“, to znači da reaguje na koncept ili objekt sa kojim se nije srela nikada pre.

Dakle, kao najprostiji primer, ako je veštačka inteligencija pravljena da prepoznaje slike životinja obučavana na slikama mačaka i pasa, pretpostavili biste da će imati problema sa konjima i slonovima.

Ali preko učenja sa nula pokušaja, ona može da iskoristi ono što zna o konjima semantički – kao što je broj nogu ili nedostatak krila – da bi uporedila njihove atribute sa životinjama na kojima jeste obučavana.

Grubi ljudski ekvivalent bio bi „informisana pretpostavka“.

Veštačke inteligencije postaju sve bolje i bolje u učenju na osnovu nula pokušaja, ali kao i kod bilo kog drugog izvlačenja zaključaka napamet, umeju da pogreše.

Pogledajte i ovu priču:

Pratite nas na Fejsbuku,Tviteru i Vajberu. Ako imate predlog teme za nas, javite se na [email protected]

Pratite nas na našoj Facebook i Instagram stranici, ali i na X nalogu. Pretplatite se na PDF izdanje lista Danas.